Luego de los reclamos de ONGs como EFF, la opinión de analistas como Edward Snowden y por haber generado más dudas que certezas, Apple se ha visto en la necesidad de salir al paso de todas las inquietudes generadas con la implementación de su sistema de scanneo de imágenes en los dispositivos de los usuarios, lo que ha generado bastante inquietud entre los mismos y para ello ha publicado un extenso documento al cual se puede acceder íntegramente aquí.

«Desde que anunciamos estas características, muchas partes interesadas, incluidas organizaciones de privacidad y organizaciones de seguridad infantil, han expresado su apoyo a esta nueva solución, y algunas se han comunicado con preguntas», se lee en las preguntas frecuentes… y este documento sirve para abordar estas cuestiones y brindar más claridad y transparencia en el proceso».

DECLARACIÓN OFICIAL DE APPLE

LO QUE SE REVISA

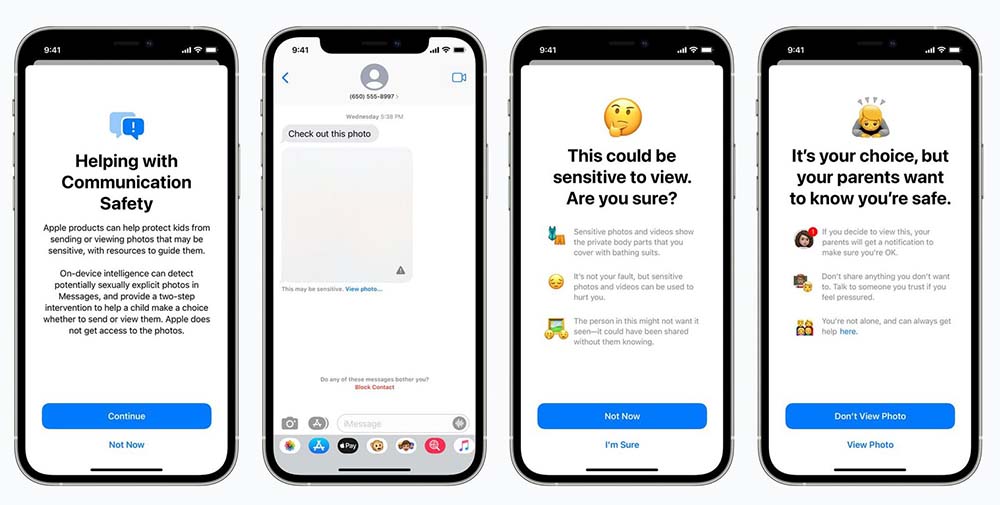

Apple aclara que el scanneo de imágenes «solo funciona en imágenes enviadas o recibidas en la aplicación iMessages para cuentas de niños configuradas en Compartir en familia, mientras que la detección de Child Sexual Abuse Material (CSAM o Material de abuso sexual infantil por su siglas en inglés) en iCloud Photos solo afecta a los usuarios que han optado por usar iCloud Photos para almacenar sus fotos … No hay impacto en ningún otro dato del dispositivo «.

Estas dos funciones no son iguales y no utilizan la misma tecnología.

La seguridad de la comunicación en iMessages está diseñada para brindarles a padres e hijos herramientas adicionales para ayudar a proteger a sus hijos del envío y la recepción de imágenes sexualmente explícitas en la aplicación y solo funciona con imágenes enviadas o recibidas en la aplicación Mensajes para cuentas de niños configuradas en Family Sharing.

Analiza las imágenes en el dispositivo, por lo que no cambia las garantías de privacidad de los mensajes. Cuando la cuenta de un niño envía o recibe imágenes sexualmente explícitas, la foto se verá borrosa y el niño será advertido, se le presentarán recursos útiles y se le asegurará que está bien si no quiere ver o enviar la foto. Como precaución adicional, a los niños pequeños también se les puede decir que, para asegurarse de que están seguros, sus padres recibirán un mensaje si lo ven.

La segunda función, la detección de CSAM en iCloud Photos, está diseñada para mantener CSAM fuera de iCloud Photos sin proporcionar información a Apple sobre cualquier foto que no sea la que coincida con imágenes de Child Sexual Abuse Material (CSAM) conocidas. La posesión de imágenes CSAM es ilegal en la mayoría de los países, incluido Estados Unidos.

Apple señala que esta función solo afecta a los usuarios que han optado por utilizar Fotos de iCloud para almacenar sus fotos y no afecta a los usuarios que no han elegido usar Fotos de iCloud. No hay impacto en ningún otro dato del dispositivo. Esta función no se aplica a los mensajes.

Del mismo modo, y uno de los temas más sensibles dice relación con el uso del sistema de detección de CSAM en Fotos de iCloud para detectar cosas que no lo sean, y según la compañía, el proceso está diseñado para evitar que eso suceda. La detección de CSAM para iCloud Photos está diseñada para que el sistema solo funcione con hashes de imágenes CSAM proporcionados por la National Center for Missing & Exploited Children’s (NCMEC o Centro Nacional de menores perdidos y abusados) y otras organizaciones de seguridad infantil.

Este conjunto de hashes de imágenes se basa en imágenes adquiridas y validadas para ser CSAM por organizaciones de seguridad infantil. No hay informes automáticos a las fuerzas del orden y Apple realiza una revisión humana antes de presentar un informe al NCMEC. Como resultado, el sistema solo está diseñado para informar fotos que se conocen como CSAM en Fotos de iCloud. En la mayoría de los países, incluido Estados Unidos, la simple posesión de estas imágenes es un delito y Apple está obligada a informar a las autoridades correspondientes de cualquier caso que sepamos.

NO A LAS SOLICITUDES DE GOBIERNOS

En caso de recibir solicitudes de parte de los gobiernos, Apple dice que rechazará tales demandas e insiste en señalar que la capacidad de detección de CSAM de Apple está diseñada únicamente para detectar imágenes almacenadas en iCloud Photos que han sido identificadas por expertos del NCMEC y otros grupos de seguridad infantil.

Apple además señala que hay otras compañías que escanean todas las fotos en la nube y que el método de Apple protege la privacidad pues tan solo se centran en aquellas fotos que encajan con una imagen CSAM y están incluidas en una fototeca de iCloud.

NUESTRA EDITORIAL SOBRE EL TEMA